Visual-RFT论文阅读-视觉慢推理

概述

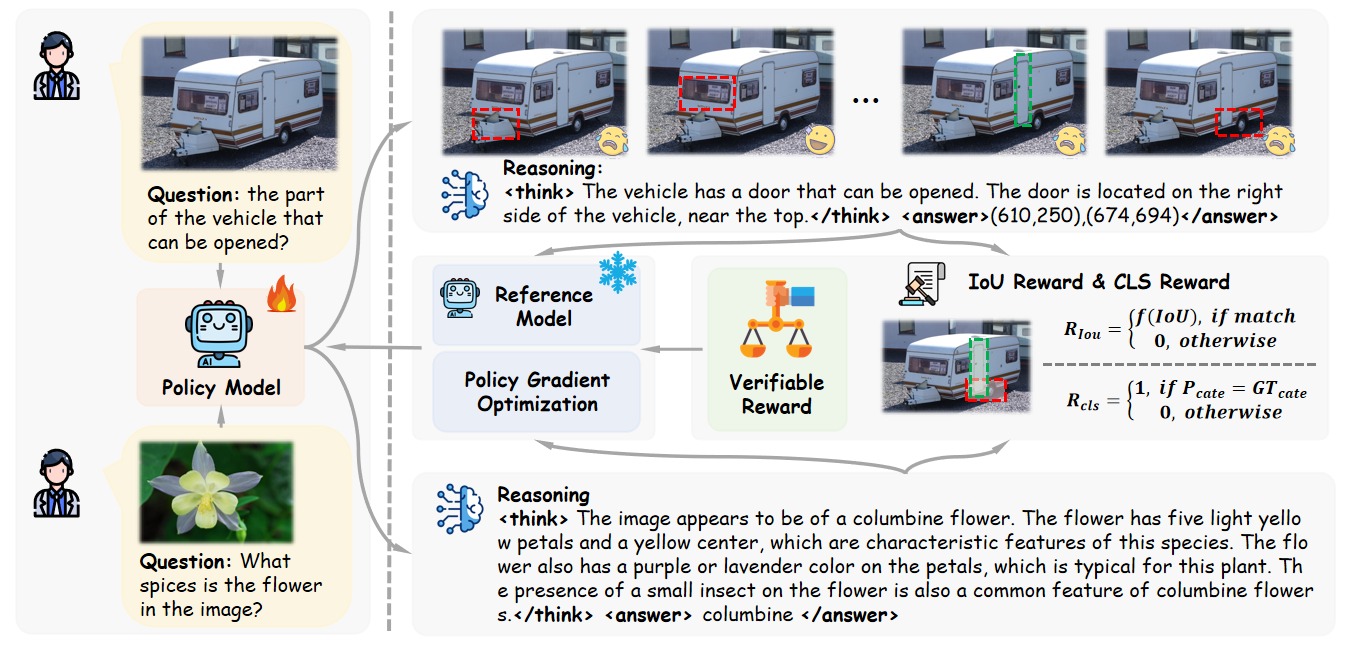

Visual Reinforcement Fine-Tuning(Visual-RFT) 是一种将强化学习应用于视觉任务的方法,旨在提升大视觉语言模型(LVLMs)的视觉感知和推理能力。它通过让 LVLMs 生成包含推理和答案的多响应,利用任务特定的可验证奖励函数(如检测任务的 IoU 奖励、分类任务的准确率奖励),借助策略优化算法更新模型。

文章的“Methodology”部分主要介绍了Visual - RFT所涉及的基础概念、方法框架以及关键组成部分,具体内容如下:

- 预备知识

- 可验证奖励的强化学习(RLVR):是一种用于提升语言模型在具有客观可验证结果任务(如数学和编程)中表现的训练方法。与传统的基于人类反馈的强化学习(RLHF)不同,RLVR不依赖训练的奖励模型,而是使用直接验证函数来评估正确性。给定输入问题$q$,策略模型$\pi_{\theta}$生成响应$o$并获得可验证奖励。其优化目标为:

[max {\pi{\theta}} \mathbb{E}{o \sim \pi{\theta}(q)}\left[R_{RLVR}(q, o)\right]=\left[R(q, o)-\beta KL\left[\pi_{\theta}(o | q) | \pi_{ref }(o | q)\right]\right]]

其中,$\pi_{ref}$是优化前的参考模型,$R$是可验证奖励函数,$\beta$是控制KL散度的超参数。可验证奖励函数$R$根据问题和输出对$(q, o)$判断预测与真实答案是否一致,若一致则$R(q, o)=1$,否则为$0$。 - DeepSeek R1 - Zero和GRPO:DeepSeek R1 - Zero算法通过Group Relative Policy Optimization(GRPO)框架,仅利用强化学习进行训练,消除了对监督微调(SFT)的依赖。对于给定问题$q$,GRPO从当前策略$\pi_{\theta_{old}}$生成$G$个不同的响应${o_{1}, o_{2},…, o_{G}}$,然后根据这些响应采取行动并获得奖励${r_{1}, r_{2},…, r_{G}}$。通过计算奖励的均值和标准差进行归一化,以确定这些响应的相对质量:

$A_{i}=\frac{r_{i}-mean\left(\left{r_{1},…, r_{G}\right}\right)}{std\left(\left{r_{1},…, r_{G}\right}\right)}$

其中,$A_{i}$代表第$i$个答案的相对质量。GRPO鼓励模型在组内选择奖励值高的更好答案。

- 可验证奖励的强化学习(RLVR):是一种用于提升语言模型在具有客观可验证结果任务(如数学和编程)中表现的训练方法。与传统的基于人类反馈的强化学习(RLHF)不同,RLVR不依赖训练的奖励模型,而是使用直接验证函数来评估正确性。给定输入问题$q$,策略模型$\pi_{\theta}$生成响应$o$并获得可验证奖励。其优化目标为:

- Visual - RFT

- 整体框架:Visual - RFT的框架中,多模态输入数据由图像和问题组成。策略模型$\pi_{6}$根据输入输出推理过程并生成一组响应。每个响应通过可验证奖励函数计算奖励,在对每个输出的奖励进行分组计算后,评估每个响应的质量并用于更新策略模型。为保证策略模型训练的稳定性,Visual - RFT使用KL散度限制策略模型与参考模型之间的差异。

- 视觉感知中的可验证奖励

- 检测任务中的IoU奖励:在检测任务中,模型输出包含边界框(bbox)和相应置信度。奖励函数需考虑用于评估平均精度均值(mAP)的交并比(IoU)指标。首先对模型输出的边界框按置信度排序为${b_{1}, b_{2},…, b_{n}}$,并与真实边界框${b_{1}^{g}, b_{2}^{g},…, b_{m}^{g}}$匹配计算IoU,设置IoU阈值$\tau$,低于阈值的边界框视为无效,未匹配的边界框IoU为0。匹配后得到每个框的IoU和置信度${iou_{1}:c_{1}, iou_{2}:c_{2},…, iou_{n}:c_{n}}$ ,由此构建奖励$R_{d}$,它由三部分组成:

[R_{d}=R_{IoU }+R_{conf }+R_{format }]

其中,$R_{IoU}$是模型输出所有边界框的平均IoU:

[R_{IoU}=\frac{iou_{1}+iou_{2}+…+iou_{n}}{n}]

置信度奖励$R_{conf}$与IoU相关,对于每个边界框,若$iou$非零(表示匹配成功),则该单个框的置信度奖励$r_{ci}$为预测置信度;若$iou$为零(表示匹配失败),则$r_{ci}$为$1 - c_{i}$。模型输出的整体置信度奖励$R_{conf}$是所有边界框置信度奖励的平均值:

[R_{conf }=\frac{\sum_{i=1}^{n} r_{c i}}{n}]

格式奖励$R_{format}$用于强制模型预测符合

- 分类任务中的CLS奖励:在分类任务中,奖励函数由准确率奖励$R_{acc}$和格式奖励$R_{format}$组成。准确率奖励通过比较模型输出类别与真实类别来确定,分类正确为1,错误为0:

[R_{cls }=R_{acc }+R_{format }]

- 数据准备:为在各种视觉感知任务上训练Visual - RFT,需构建多模态训练数据集。与DeepSeek R1类似,Visual - RFT设计了提示格式,引导模型在给出最终答案前输出推理过程。检测和分类任务使用的提示格式分别规定了输出的具体要求,如检测任务需按特定格式输出检测对象的边界框、置信度及推理过程;分类任务需按格式输出植物物种识别的推理过程和结果。在训练过程中,利用格式奖励引导模型以结构化格式输出推理过程和最终答案,推理过程是模型在强化微调中自我学习和改进的关键,而答案确定的奖励则指导模型的优化方向。